Deepfakes: o quanto devemos nos preocupar?

Se as últimas eleições americanas, britânicas e brasileiras nos ensinaram alguma coisa, essa lição foi que na era digital as fake news não têm limites, tanto em relação ao absurdo de seu conteúdo, quanto em relação à sua capacidade de propagação e suas consequências políticas. Vivemos tempos em que a informação está ao alcance das mãos e em que, ao mesmo tempo, a população mundial está totalmente desinformada.

Enquanto a imparcialidade dos grandes veículos é questionada, os internautas se informam muitas vezes pelas redes sociais, principalmente Facebook e WhatsApp, e por veículos que sequer possuem um trabalho de apuração e checagem de fatos. Isso sem considerar os bots que atuam 24 horas por dia espalhando notícias falsas, a serviço de quem pagar.

Talvez o cenário piore com as deepfakes. Antes só era possível gerar desinformação com textos e fotos manipuladas, agora o deepfake vai possibilitar a alteração de imagens e sons humanos em vídeo, com base em técnicas de inteligência artificial.

Onde está a tecnologia hoje

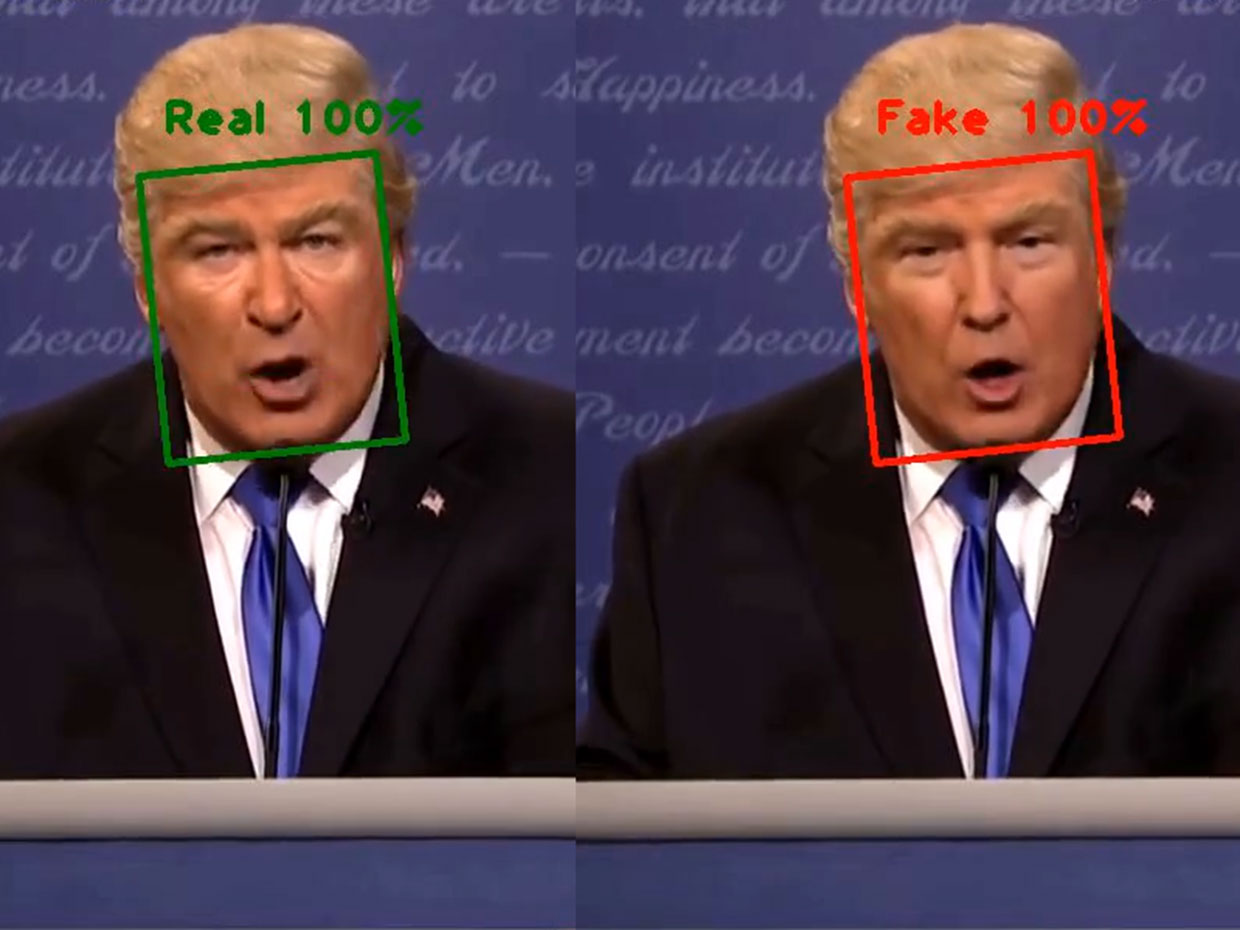

O termo deepfake surgiu em dezembro de 2017 por conta de um usuário do Reddit que usava tecnologia de aprendizagem profunda para editar os rostos de celebridades em vídeos pornográficos. A criação de um deepfake é possível por meio de dois sistemas de inteligência artificial, sendo um o "generator" e o outro o "discriminator"; o gerador cria um vídeo falso e pergunta ao discriminador se trata-se de um material real ou falso. Todas as vezes que o discriminador identifica corretamente que o vídeo é fake, ele dá ao gerador uma dica do que não fazer ao gerar o próximo vídeo.

Juntos, esses dois programas formam o que é chamado de "generative adversarial network (GAN)" e o primeiro passo para criar uma rede dessas é identificar o resultado desejado e criar um treinamento para isso. Assim, a cada vídeo gerado e avaliado, os dois programas ficam melhores em produzir os vídeos falsos e em identificá-los. Como utilizam inteligência artificial, eles não necessitam de habilidades para produzir vídeos realistas, permitindo que qualquer pessoa possa criar um deepfake para promover qualquer coisa, de produtos a ideias políticas.

Qualquer pessoa mesmo. Um novo software usa aprendizado de máquina para permitir que usuários editem o texto transcrito de um vídeo para adicionar, deletar ou alterar as palavras ditas por alguém em um vídeo. Obviamente, existem limites para o que os deepfakes podem fazer: eles dependem de 40 minutos de informações, o áudio não pode diferir muito entre os materiais e o tom de voz dos oradores, o que deixa as falas pouco naturais.

Essas são questões facilmente resolvidas com o desenvolvimento da tecnologia e, possivelmente, não serão um problema durante muito tempo, já que o aprendizado de máquina e a inteligência artificial melhoram constantemente e rápido.

Os deepfakes se voltam para política, devemos nos preocupar?

O meio político ficou preocupado com as chances de desmoralização que os deepfakes possibilitam. Afinal, se qualquer pessoa pode editar um vídeo para alterar as falas do orador, qual seria o limite para que grupos ou partidos opostos utilizassem essa tecnologia para sujar a imagem de seus oponentes? O Senado americano está bastante preocupado e criou uma lei para proibir o uso da tecnologia. Sua tramitação já está em andamento.

Em 2016, Jimmy Fallon apresentou uma sketch em que ele, vestido como Donald Trump, fingia conversar com Barack Obama pelo telefone. Neste ano, um usuário chamado deepfake publicou um vídeo em que os rostos na sketch foram substituídos pelos políticos de verdade. Segundo o usuário, o vídeo não tem motivação política e foi feito apenas por motivos humorísticos, porém muitas pessoas assistem ao vídeo com apreensão e acreditam que essa tecnologia poderia ser usada para desonrar políticos e até mesmo mudar eleições.

Por enquanto, conhecemos apenas uma tentativa confirmada de um partido político usar um vídeo deepfake para influenciar diretamente uma eleição: em 2018, um partido flamengo postou um vídeo em profundidade nas suas páginas do Twitter e do Facebook mostrando Trump insultando a Bélgica por permanecer no acordo climático de Paris. Pode ser que existam muitos outros casos, até agora não detectados.

Há quem acredite que os deepfakes são mais assustadores do que realmente perigosos. Anos após sua primeira aparição no Reddit, ainda não é possível encontrar por aí muitos vídeos com políticos como alvo de conspirações verdadeiras. Em sua maioria, os vídeos falsos foram desenvolvidos pela mídia, para demonstrar a capacidade dos deepfakes. Isso é bastante surpreendente se considerarmos que os trolls envolvidos com política estão mais ativos do que nunca na web.

Mesmo fácil de usar, barata e altamente disponível, os bots continuam a compartilhar artigos falsos, ao invés de vídeos. Isso poderia acontecer, em parte, porque ainda é fácil identificar os deepfakes; o Facebook vem utilizando seu sistema para filtrar vídeos alterados desde setembro do ano passado. Existe outra questão importante: artigos falsos não apresentam provas, mas são o suficiente para pessoas já convencidas de algo reiterem suas crenças. Por enquanto, o dano está acontecendo por meio da pornografia, inserindo mulheres em filmagens sexuais sem consentimento. Sua base é muito mais misógina do que propagandista e política.

De qualquer maneira, não existem dúvidas de que os deepfakes são uma verdadeira pedra no sapato dos políticos com a chegada das eleições americanas em 2020. Esses vídeos podem mudar de montagens pornográficas para clipes que possam espalhar a desinformação e desestabilizar governos. Os potenciais de danos são enormes, um vídeo falso que apresentasse um líder mundial dizendo algo problemático, por exemplo, desencadearia uma instabilidade em grande escala.

Com o app chinês Zao deepfakes se tornam virais

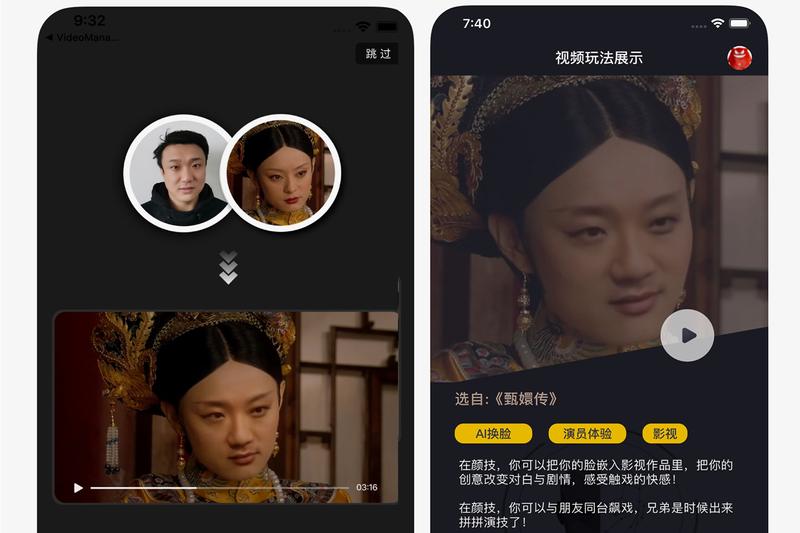

Em maio deste ano, a China protagonizou um verdadeiro boom do deepfake. O aplicativo Zao, que troca o rosto de uma pessoa em filmes e cenas de TV, viralizou na app store da Apple. Usar o app não poderia ser mais simples – basta enviar uma selfie para o aplicativo que será colada no rosto de grandes estrelas do cinema e da televisão. Só é possível enviar a foto para cenas específicas disponíveis no aplicativo, não sendo possível colocar o rosto de alguém em cena criminosa, por exemplo.

Os usuários aderiram ao Zao porque o app é divertido, em compensação sua política de privacidade não agradou, por isso recebeu milhares de resenhas negativas na Apple Store. O Zao é desenvolvido pela empresa Changsha Shenduronghe Network Technology, subsidiária de uma empresa chinesa que possui serviços de streaming e relacionamentos. A política de privacidade inclui uma cláusula que diz que o desenvolvedor tem "livre, irrevogável, permanente, transferível e passível de re-licenciamento" a todo o conteúdo gerado pelos usuários. Após a polêmica, os desenvolvedores declararam que não manteriam os dados dos usuários.

O caso é parecido com o FaceApp, que mais cedo neste ano viralizou envelhecendo fotos dos usuários e levantando questões sobre privacidade de dados. Na China, a discussão sobre privacidade é ainda mais acalorada, uma vez que a polícia está utilizando reconhecimento facial para identificar e prender procurados. Os chineses parecem estar ainda mais conscientes a respeito dos dados de imagens e sobre a forma que eles serão utilizados.

Um artista contra suas própria criações

Hao Li é um cientista de computação inovador, desenvolvedor de tecnologias que encantam políticos, CEOs e atores famosos. Mas não é apenas por isso que Li é uma personalidade interessante, acima de tudo ele quer conscientizar a respeito dos perigos do deepfake. Como um dos pioneiros da tecnologia, em 2009, anos antes do surgimento dos deepfakes, Li desenvolveu uma maneira de capturar o rosto de uma pessoa e utilizá-lo para operar um fantoche virtual. Hoje, ele teme que esse seja apenas o começo de uma era em que não poderemos crer em nossos olhos e quer fazer algo antes que seja tarde demais.

O desenvolvedor trabalha constantemente com atores de Hollywood, fazendo scanners de suas suas aparências para que grupos de efeitos especiais possam manipular as imagens e adicionar atores em cenas na pós-produção dos materiais. Ele também vai além, pesquisando como tecnologias podem auxiliar a encontrar tumores dentro do corpo e modelar as propriedades de ossos e peles.

Ele acredita que estamos de frente a um sério problema. Ele e outros desenvolvedores se posicionaram recentemente por meio de um release sobre a criação de uma maneira nova e mais poderosa de descobri-los. Isso seria possível por meio de um algoritmo de aprendizado de máquina que reconheceria as expressões faciais individuais de pessoas, o que facilitaria reconhecer um deepfake. Essa não seria uma solução definitiva, já que de acordo com Li, deixar os deepfakes perfeitos é apenas uma questão de tempo e recursos.

Estamos sem ferramentas para lidar com os deepfakes, dizem cientistas

A tecnologia evolui e nós precisamos encontrar formas de deter seu uso indiscriminado, pesquisadores de inteligência artificial buscam maneiras de desarmar essa bomba, tarefa dificílima. Eles desenvolveram sistemas automáticos que podem analisar os vídeos para encontrar indicadores de que sejam fakes, como padrões na maneira como uma pessoa pisca ou avaliação da luz do vídeo, tanto do fake como da pessoa real.

A ferramenta se desenvolve e se espalha de maneira tão rápida, que os especialistas sentem-se desarmados, já que para cada cem pessoas desenvolvendo deepfake, existe uma trabalhando para detectá-la. Isso sem contar com o fato de que o compartilhamento dos usuários é muito mais rápido do que o tempo em que os programas detectam as deepfakes e que as falsificações não precisam ser tão convincentes para causar impactos. O compartilhamento acontece, mesmo com notícias e vídeos claramente falsos.

O medo causado pelos deepfakes também já causa impactos na vida das pessoas. Um estudo da Pew Research mostra que cerca de dois terços dos pesquisados acreditam que vídeos e imagens alterados se tornaram um grande problema para a compreensão dos fatos básicos dos eventos atuais, enquanto mais de um terço disse que "notícias inventadas" os levaram a reduzir a quantidade de notícias que recebem no geral. As pessoas podem acabar, ainda, por levar as pessoas a negar vídeos legítimos.

No meio da inteligência artificial, identificar falsa mídia sempre recebeu menos atenção, recursos e suporte institucional do que criá-la. A maior parte do dinheiro destinada a isso vem de uma agência do Pentágono, que em 2016 lançou um programa de patrocínio a mais de uma dúzia de grupos de pesquisa. Segundo seus pesquisadores, o truque para desvendar um deepfake é criar uma ferramenta que funcione no que os grupos de criptografia chamam de "ambiente sem confiança", no qual é possível rastrear detalhes do criador, origem e distribuição do vídeo.

Por meio de um novo método, pesquisadores de universidades californianas construíram um sistema de inteligência artificial que alimentava horas de vídeo de líderes de alto nível e treinava para procurar por "unidades de ação facial" hiper-precisas, que são pontos de dados de seus movimentos faciais, tiques e expressões, inclusive quando elevam os lábios superiores e como a cabeça gira quando franzem a testa. Os desenvolvedores querem que empresas midiáticas tenham acesso à ferramenta de detecção de deepfake, mas têm medo de que deixar o sistema mais disponível possibilite que os criadores das deepfake confiram o código e encontrem formas de burlar o sistema.

O Facebook está trabalhando em uma estratégia própria para lidar com isso, fazendo muitos deepfakes por conta própria para ajudar os pesquisadores a criar e refinar ferramentas de detecção. Esses clipes servirão como um conjunto de dados para ferramentas de teste e benchmarking de detecção de deepfake. Os softwares que conseguem detectar os vídeos manipulados IA apenas fornecerão uma correção parcial para o problema, afirmam especialistas. Assim como vírus de computador, por exemplo, os deepfakes agora são parte de nossa vida on-line. Essa seria uma solução temporária, já que com o tempo os vídeos vão melhorar e sua detecção ficará mais fácil.

Legislação e regulação contra deepfakes

O Congresso e vários estados americanos estão considerando a primeira legislação contra vídeos e áudio alterados pela IA, por meio de uma enxurrada de leis. Um senador já presentou um projeto de lei para criminalizar a criação e distribuição maliciosa de deepfakes. Em Nova York, uma lei estadual puniria as pessoas que conscientemente criam vídeos digitais, fotos e áudio de outras pessoas, incluindo deepfakes, sem o seu consentimento.

Outros legisladores estão pensando sobre o assunto e convidaram especialistas em direito para informar seus funcionários em particular sobre deepfakes e considerando a legislação de proibição. A lei puniria, com uma multa e/ou até dois anos de prisão, ou se o deepfake puder incitar violência ou atrapalhar o governo ou uma eleição – até 10 anos, criadores de deepfake individuais, se agirem com a intenção de fazer algo ilegal, e distribuidores, como o Facebook, apenas se souberem que estão distribuindo um deepfake. Isso significa que as plataformas podem configurar um sistema de relatórios, como os usados para suprimir filmes piratas, e derrubar deepfakes quando forem notificados.

Alguns especialistas em direito acreditam que a lei atribui uma responsabilidade excessiva aos distribuidores, podendo assustar as plataformas e acabar com tudo o que é relatado como uma falha profunda – potencialmente excluindo postagens legítimas no processo. Outros acham que o Congresso sequer deve intervir, pois a proibição dos deepfakes pode interferir na liberdade de expressão, como a criação de vídeos de paródia.

Como podemos nos proteger como sociedades

Basicamente, os especialistas das áreas jurídica e de inteligência artificial discordam bastante e ainda não há um consenso sobre o que fazer. Estamos perdidos em um uma rede de notícias e vídeos falsos? Talvez. A verdade é que precisamos de regulamentações específicas que lidem com isso, que realmente acertem um equilíbrio entre a responsabilidade do criador do deepfake e da empresa que o distribui, caso ela não tome nenhuma ação em relação a este conteúdo.

Temos que aceitar que os deepfakes são parte de uma realidade em que vivemos que, infelizmente, fica cada vez mais difícil de assimilar. É preciso que estejamos sempre atentos e críticos ao conteúdo que consumimos e compartilhamos nas redes, sobretudo aqueles que colocam em risco a integridade de outras pessoas.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.